REALIDAD Y FICCIÓN FILOSOFÍA, LITERATURA, ARGUMENTACIÓN, CIENCIA, ARTE

lindaraja REVISTA de estudios interdisciplinares y transdisciplinares. ISSN: 1698 - 2169

|

|

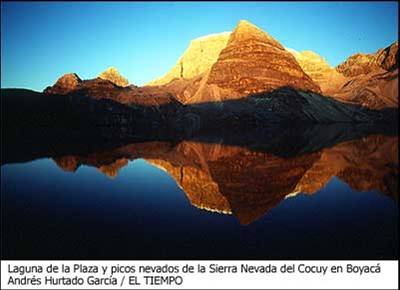

Laguna de la Plaza y

Picos nevados de la Sierra de

Cocuy en Boyacá (Colombia)

Revista Lindaraja

nº 11,

julio de 2007

Rosa Nidia Tuay

“Si nos ocupamos solamente del conocimiento

como representación de la naturaleza,

nos preguntamos cómo

podremos alguna vez escapar de las

representaciones y

conectarnos al mundo”(Hacking 1992)

Consideraciones iniciales

Cuando se inicia una indagación filosófica se debe tener presente que el problema a tratar sea de carácter central en las discusiones, esto permitirá que se pueda examinar a fondo, captar sus dificultades e implicaciones y contribuir al planteamiento de una solución. Las discusiones de los filósofos de una época se centran en los problemas que consideran relevantes, su tarea es idear soluciones determinantes que ayuden a que este sea algo vivo, de especial importancia no solo para la comunidad de filósofos sino para la cultura en general.

Las representaciones científicas han personificado un tema de debate en los últimos años desde ámbitos como la sociología de la ciencia, la economía de la ciencia, hasta las temáticas centrales de la filosofía. La representación es un concepto que se ha venido discutiendo en la filosofía de la ciencia y al interior de su quehacer. Es un concepto que no está bien establecido, constituyéndose en una problemática ha ser abordada en trabajos de investigación.

Se considero importante, abordar primero, el concepto de representación a través de autores como Hacking(1992) y Woolgar(1991), quienes han mostrado una posición divergente frente al tema; en una segunda parte, se buscó acercarse a una posible teoría de la representación científica de Ibarra y Mormann (2001), así como el debate que propone Suárez(2004) para precisar si las relaciones de isomorfia o de similitud se constituyen en una condición necesaria y/o suficiente para la existencia de una representación. En una tercera parte se analizó la concepción de teorías como modelos desde las perspectivas de Hughes (1997), Giere(2004), Morrison-Morgan(2004) y Knuuttila(2005) , para armar un panorama general que se contrastará con la visión de los científicos acerca de la concepción de modelos en la ciencia. Por último se tomará como ejemplo de modelo teórico las formulaciones de la mecánica cuántica de Schröndinger y Heisenberg, que han sido abordadas en los textos de física mostrando preferencias de una frente a la otra en su enseñanza.

Una de las tareas propuestas es hacer un acercamiento a las distintas posiciones desde las que se ha abordado el tema de las representaciones científicas. A lo largo de la historia de la ciencia, el tema del conocimiento ha sido trabajado por filósofos como Platón y Descartes, pero éste comenzó a tener una mayor fuerza desde los años setenta con las teorías cognitivas. Una tesis central de estas teorías es que toda cognición es manipulación de representaciones. El concepto de representación tiene implicaciones ontológicas y epistemológicas, es decir, se da por supuesto que el mundo es predefinido, que hay rasgos definidos antes de cualquier actividad cognitiva y, para establecer una relación entre ellos, se plantea la existencia de representaciones mentales dentro del sistema cognitivo (imágenes, símbolos). Éste último permitirá establecer una teoría, en la cual el mundo es predeterminado, la mente posibilita el conocimiento de éste y permite representar los rasgos característicos para luego actuar sobre ellos.

Por lo menos tres diferentes posiciones respecto al problema de la representación se pueden encontrar[1]. Algunos desean renunciar a ésta y simplemente evaden el problema, definiéndolo como improductivo y estéril. Entre éstos se encuentran Rorty (1980) y Hacking (1992). Por otro lado, otros intentan deconstruir la noción como Hughes (1987) y Woolgar (1991). Al hablar sobre la representación se está haciendo referencia a las maneras de dar, de denotar e indicar, entre otras. Esto no conlleva al encuentro de un centro común que pueda llamarse ‘las representaciones’. Por último, distintos autores buscan reconstruir la noción de representación de una manera que preste atención debida a la crítica, como lo son Ibarra-Mormann (2001), Suárez (2004) y Knuuttila (2005).

La idea de que los sistemas cognitivos tienen capacidad para elaborar representaciones y que en eso se centra su función ha sido duramente criticada desde la filosofía –ejemplo Rorty (1980)-, la sociología de la ciencia y algunos campos de las ciencias cognitivas. En la década de los noventa, en esta última disciplina, algunos autores se posicionaron en contra, ya que rechazaron el postulado sobre las representaciones mentales como condición necesaria para explicar el funcionamiento de los sistemas cognitivos.

El ámbito actual de la filosofía de la ciencia muestra una gran variedad teórica acerca de la concepción de modelos, teniendo en cuenta un carácter formal y práctico que ha veces resulta contradictorio cuando se quiere hacer una aproximación a los modelos como representaciones, sin embargo este trabajo de investigación tiene como propósito buscar una aproximación a este debate, sin tener en cuenta las concepciones acerca del conocimiento científico, sólo la categoría de cómo se conciben las representaciones.

Posiciones de Hacking y Woolgar

Las propuestas planteadas desde ámbitos como la filosofía de la ciencia y de la sociología de la ciencia acerca de las representaciones, permite una fundamentación del tema, abordando sus concepciones y soluciones, es claro que se ubican en maneras diferentes de abordar el conocimiento científico, pero nos dan elementos de análisis para abordar el tema la temática propuesta.

En la década de los años ochenta Hacking publica su libro “Representar e intervenir”, en el que propone un cambio en el enfoque de la filosofía de la ciencia. La primera tarea del ser humano consiste en la representación, la cual permite construir la realidad más no pretende decir como son los objetos. En la tarea representacional surge la similitud mundo- objeto, que se relaciona con las prácticas de representación indirectamente. En la física no existe una verdad única sino una variedad de representaciones que dan cuenta de cómo es el mundo. Sin embargo, es necesario hacer referencia a los experimentos y la tecnología, y en eso se centra la propuesta de Hacking[2]. Él señala que hay que pasar de la verdad y de la representación a la experimentación y manipulación: “siempre hay pugna entre el realismo y el antirealismo tratando de probar, que hay algo en la naturaleza de la representación que vencerá el otro, quedando por lo tanto inconclusa esta discusión” (Hacking 1992:173)[3]. La experimentación debe recobrar su sitio central en el campo de la ciencia y de la filosofía de la ciencia, pues ante todo ésta ha sido una filosofía de las teorías. El concepto de observación también está cargado de teoría y esto ha hecho que este término se considere esencial en la práctica científica,

La observación, en el sentido filosófico de producir y registrar datos, es sólo un aspecto del trabajo experimental. Es en otro sentido que el experimentador debe ser un buen observador-sensible y alerta. Sólo un buen observador puede llevar a cabo un experimento, detectar los problemas que impiden el desarrollo del experimento, modificarlo de la manera adecuada, distinguir si algo fuera de lo común es una clave de la naturaleza o si es un artefacto de la máquina (Hacking 1992:173).

Existe una triple relación entre los modelos, la especulación, el cálculo y las aproximaciones, en la concepción de una teoría científica. Por un lado, la especulación es la “representación intelectual de algo de interés, un juego de reestructuración de las ideas que nos lleva por lo menos a un entendimiento cualitativo de alguna característica general del mismo” (Hacking 1992:242) que se puede expresar en modelos físicos o estructuras matemáticas enlazados en una dinámica permanente a lo largo de la historia de la física. La especulación y el experimento están articulados por el cálculo, esto permite una unión cuantitativa entre la teoría y la observación. En este puente hay una dinámica asociada a la construcción de modelos.

El concepto de modelo ha tenido diferentes connotaciones. Su definición ha pasado desde la idea de artefactos físicos constituidos por elementos básicos hasta el concepto en la ciencia física como algo que está en la mente y no es un objeto como tal, “hay una mezcla entre lo pictórico y lo matemático” (Hacking 1980:245) que se pueden usar indistintamente para diferentes problemas. El modelo es lo que permite la conjunción entre las teorías y los fenómenos; pero las relaciones entre estos no es simple, ya que nada parece acercarnos a la verdad, “las relaciones de los modelos con la teoría y con los fenómenos son variadas y complejas” ( Hacking 1992:247).

Los fenómenos son creados por los científicos en la realización de los experimentos y después cobran lugar dentro de las teorías, es decir, “los humanos hacen las llaves, y tal vez también las cerraduras en las que se dan vuelta” (Hacking 1992:257). Experimentar se convierte en una tarea compleja, ya que implica “(...) crear, producir, refinar y estabilizar fenómenos” (Hacking 1992:259)[4], donde la habilidad del experimentador juega un papel preponderante, pues no es suficiente con la toma de datos sino que es importante saber cuando funciona el experimento. Esto último trae como consecuencia que no es posible repetir una práctica, puesto que las condiciones técnicas cambian y se trata siempre de mejorarlo, más no de repetirlo.

La experimentación es la que permite dar cuenta de la realidad y da paso a que el científico sea un realista. Las entidades “(...) son herramientas, instrumentos para hacer y no para pensar” (Hacking 1992:291), de ahí la importancia del trabajo experimental, por eso el realismo acerca de las entidades está centrado en el quehacer “las entidades teóricas que no terminan siendo manipuladas terminan, por lo general, siendo tremendos errores” (Hacking 1992:304), cuando un científico manipula una entidad tiene la convicción de que su existencia es tan real como la de un objeto macroscópico. Según Hacking, la obsesión con las representaciones ha conllevado a una imagen donde el pensamiento y la teoría dan cuenta de la realidad. En ésta última, las observaciones y la manipulación de un ente en los experimentos deben ocupar su lugar.

Se busca la realidad alojada en el lugar científico -la práctica-, pues solo tiene sentido sí ésta es manipulada en un laboratorio, en donde la representación no tendría un lugar predominante, sino que sería desplazada por la experimentación, la manipulación y todas las tareas que impliquen el trabajo experimental[5].

Las prácticas científicas se constituyen en el mejor apoyo con que cuenta para dar la realidad, dejando de lado los procesos de representación y la elaboración de teorías. A pesar de que esta demanda se ha presentado en el contexto de la ciencia, se pretende quitar el lugar de preponderancia al tema representacional mantenido al interior de esta.

Suárez (2003b: 261-284), ubica la obra de Hacking en la línea de los defensores del nuevo experimentalismo, ya que da preponderancia al papel de la práctica experimental, y al conocimiento fenomenológico del mundo, independiente del conocimiento teórico. La mayoría de los experimentos no están previstos para verificar teorías sino para establecer enunciados fenomenológicos, y modelos de los fenómenos. El papel de los experimentos en la ciencia no se reduce a la verificación empírica de una teoría, sino que ha promulgado “los experimentos tienen vida propia”[6], ya que se constituyen en modelos de los fenómenos.

La noción de manipulación experimental, qué Hacking profesa, no parece tener éxito en su tarea de reemplazar el realismo de la representación. En un primer momento, encaja bien sólo en aquellas actividades científicas que permiten la experimentación, así que no es particularmente conveniente para las ciencias sociales, para las cuales el trabajo científico es relevante, pero no es considerada de la misma naturaleza de las ciencias experimentales. En el caso del trabajo científico, en áreas en que la producción intelectual es la tarea principal, la existencia de entidades denominadas teóricas es problemática, pues, según el planteamiento de Hacking, el argumento de experimental no pueden aplicarse a la manipulación de estas entidades en otras áreas del conocimiento, de la misma manera que se hace en las ciencias naturales. Un ejemplo de esto está dado en los problemas de la economía. Aparte de la dificultad de dirigir los experimentos en este campo, los conceptos de lo experimental y la manipulación son confusos, pues las entidades teóricas de la economía (como “el consumidor” o “la empresa”) no son fáciles de entender, para las áreas diferentes a esta. Los esfuerzos por evitar o renunciar a la representación hacen que el trabajo en las ciencias experimentales se de al nivel de las declaraciones. Pues, cuando se comienza a visualizar en cómo el científico interviene, según la expresión de Hacking, existe el compromiso con procesos complejos que involucran artefactos especializados que graban, trazan, visualizan, etc. Hacking concede importancia a los instrumentos científicos, puesto estos permiten materializar los saberes teóricos y prácticos de los científicos que estos pueden materializar en los debates, pues se pide volcar la mirada más a la observación científica en tanto acción y menos a los resultados experimentales, ya que éstas están más cargadas de técnica y de intervenciones humanas previas que de teoría.

Otros que centraron la atención sobre el tema representacional han sido los sociólogos, entre los que se encuentra Woolgar (1979), quien afirma que el acercamiento sociológico a un problema particular debe hacerse en términos de su relatividad social, lo cual permitirá indagar sobre la fuente, el alcance y las características de las variaciones. Éstas están asociadas a la diferencia en la clase social, la filiación religiosa, la sociedad, la cultura, entre otras variables.

Esta aproximación al tema de las representaciones científicas tiene matices diferentes. Los sociólogos de tipo etnometodológico se han esforzado por indagar cómo se producen los hechos en el trabajo científico. Construyen historias de laboratorio donde describen “realmente” lo que ocurre en la práctica científica. Esto no sólo llevó a las discusiones del problema de reflexividad Woolgar (1991) sino también a estudios en cómo las representaciones se construyen con la ayuda de medios diversos y procedimientos (Lynch 1985), cómo ellos funcionan como “los lugares activos” (Amann y Knorr Cetina 1990) y cómo guían las diversas actividades (Latour 1990).

Los puntos de vista del estudio sociológico de la ciencia consisten en “(...) aceptar que la ciencia y la no ciencia no pueden distinguirse mediante reglas de decisión” (Woolgar 1991) y que el conocimiento científico es el resultado de intrincados procesos sociales. Las reglas de decisión actúan post hoc de la práctica científica y permiten dar una mirada retrospectiva sobre la acción científica. Algunos de los representantes de esta línea consideran estas reglas como elementos determinantes del quehacer científico y la existencia de factores sociales agregados que dan elementos de juicio en la explicación de la evolución de la ciencia.

Históricamente, el carácter de la ciencia ha estado en cambio continuo. Tanto la respuesta filosófica como la histórica han mostrado variaciones en las apreciaciones y esto se puede explicar desde dos posiciones denominadas esencialismo y nominalismo. El argumento esencialista considera que existe algo ‘ahí fuera” llamado ciencia, cuya naturaleza es cambiante y compleja. Por su parte, la propuesta nominalista frente al problema de la demarcación de las características de la ciencia surge de las prácticas de definición de los participantes y, ésta siempre se encuentra abierta a la reclasificación y a la renegociación. Por lo tanto, no existen ni la ciencia ni el método científico, pues estos se deben a diferentes prácticas y comportamientos.

La tarea que se propone Woolgar es caracterizar la posición esencialista -la idea de que los objetos existen independiente de la percepción que se tenga de ellos- desde la representación -que es el medio por el cual se generan imágenes de un objeto situado ‘ahí afuera’- y presentar argumentos para resistirse a esta posición.

La supuesta distinción entre representación y objeto conlleva a un dualismo, que pretende buscar características que se encuentran fuera de los límites de las actividades de la ciencia. Frente a esto se formulan preguntas base, entre las que se encuentran “¿cómo podemos estar seguros que el lado izquierdo (representación) es un verdadero y apropiado reflejo del derecho (objeto)?” o, de tipo metodológico, “¿qué fundamento garantiza la relación existente entre los objetos de estudio y las afirmaciones hechas sobre tales objetos?” (Woolgar 1991:47).

El problema de la adecuación entre representación y objeto se puede presentar en la forma de desastre metodológico, que consiste en la indexabilidad, la interminabilidad y la reflexividad. En primera instancia, la indexabilidad hace referencia a las realidades que subyacen a las representaciones, que son cambiantes en función del uso. Como consecuencia de esto, frente al intento de lograr una representación, aparecen distintas versiones que no permiten tener certeza de lo que se está representando. A su vez se encuentra la interminabilidad, que sustenta el significado de cualquier representación de manera infinita. Por lo tanto, es imposible una explicación suficiente del significado de una representación. Por último está la reflexividad, que abandera la idea de que la conexión entre el objeto y la representación es en doble dirección, es decir, que el uno apoya al otro.

Como solución al problema del desastre metodológico, que aparece en todo acto interpretativo, se han planteado cuatro estrategias (Woolgar 1991: 48):

- Apelar a una jerarquía de conocimientos: Ésta consiste en negar la generalidad del problema, buscando estatus en las situaciones, siendo la ciencia la de mayor fiabilidad. Esto incurre en una petición de principio. La tarea del estudio social de la ciencia es indagar que características de esta última le dan esa superioridad.

- Interpretar el problema como una simple dificultad técnica: Los problemas metodológicos se tratan como si fueran dificultades técnicas, que aparecen esporádicamente debido al uso de procedimientos de representación defectuosos. Sin embargo, el problema permanece ahí.

- Negar la importancia del problema: El mismo problema es artificial y engañoso, pues no pasa de ser un ejercicio filosófico artificial. Para las personas, los desastres metodológicos no son importantes, entonces para qué estudiar sus acciones cuando no son conscientes de ellos. Sin embargo, los argumentos si resultan válidos cuando se pretende aclarar controversias y se apela al relativismo como solución a éstas.

- Interpretar el problema como algo ajeno: Los desastres metodológicos aparecen en el trabajo de los demás, pero el propio es ajeno a ellos. Esta estrategia se usa en las ciencias sociales para abordar los análisis que tienen algún tipo de relativismo, en cuanto permite abordarlos en la investigación.

El estudio social de la ciencia debe enfrentarse a la idea de la representación y presenta dos modos para abordarla. El primero corresponde a la inversión. Según éste, los objetos descubiertos se constituyen a través de su descubrimiento y critica la conexión unidireccional entre la representación y, el objeto o la idea de que los dos objetos son distintos. El otro es la retroalimentación, que resalta las conexiones bidireccionales entre el objeto y el intento de llevar a cabo un estudio de la ciencia. De ese modo la ciencia no es una materia de estudio distinta ni separada de los investigadores.

Con estas dos ideas expuestas por Woolgar se espera “abrir la caja negra” de la ciencia, asumiendo que las representaciones se construyen con la ayuda de medios diversos y procedimientos y, que se debe unir esfuerzos por escapar de las representaciones científicas como única opción de abordar el trabajo científico.

Los etnometodologos lograron el éxito haciendo el trabajo científico material y visible. Sin embargo, este aspecto “antropológico de la observación” contribuye a lograr un entendimiento muy superficial de los métodos de diferentes disciplinas. Analizaron diferentes experimentos realizados a lo largo de la historia de la ciencia, algunos más conocidos que otros, unos fructificaron y otros se abandonaron en el camino; desde los fallos en los experimentos de Pasteur hasta el reciente escándalo de la “fusión fría”, pasando por experimentos que sirvieron para “demostrar” la teoría de la relatividad, por el estudio de la vida sexual de las lagartijas de cola de látigo o por la investigación sobre los neutrinos solares. Ellos han“(…) descrito no sólo los trabajos de los científicos más venerados, los Einstein, Newtons y Pasteurs, sino también los de otros que no merecerán, al parecer aclamación: los grandes flujos de ondas gravitatorias de Joseph Weber y la transferencia de memoria de Ungar y McConnell” (Collins 1986).

En lugar de evadir la pregunta de representación, estudiosos en el campo de la ciencia y tecnología han intentado abordarlo de frente. Inspirados por la etnometodología han ido “al campo” a observar que hacen los científicos “realmente” para representar. Se han dedicado al estudio de deconstruir la representación científica en la compleja fabricación de los procesos, haciendo uso de “los documentos “o “las inscripciones”. Los resultados de los experimentos se recogen en una hoja de cifras, que el ordenador transforma en hoja de datos y produce una sola curva, con sus picos y senos determinantes, que servirán de soporte para el posterior artículo. Las inscripciones de los sofisticados aparatos están en relación directa con la sustancia original del experimento; las transforman en un documento escrito. Esto da la impresión de un derroche de recursos económicos para la producción de una hoja escrita. Los científicos manejan un enorme volumen de material desordenado que deben ordenar para darle sentido al estado caótico del conocimiento como consecuencia de las informaciones sesgadas de su descubrimiento o, incluso, del ocultamiento de la información.

Las representaciones se vuelven elementos que deben ser estudiadas. En este caso, en lugar de preguntar por el significado, se aborda la representación, examinando “los documentos representativos”, donde los estudios son realizados por los participantes. Lo que sigue de este acercamiento es que en los procesos de construcción de las representaciones científicas los estudiosos siguen “la línea de la asamblea” y consideran que los hechos de la actividad científica contemporánea no solo suceden en los laboratorios, sino que suceden en las controversias científicas y en la forma que éstas finalizan. Se pasa de analizar los problemas de laboratorio a los problemas en las controversias científicas.

A menudo el objetivo de la representación es moldear el objeto científico, haciendo uso de diferentes dispositivos textuales, para que asuma una forma matemática que le permita ser descrito fácilmente. La representación científica enfrenta en estos estudios un proceso circular, poniendo en un orden los rastros fotográficos, los diagramas, las grabaciones, los mapas y las entrevistas. A esto Collins denomina la “circularidad del experimentador” Esto implica que la competencia de los experimentadores y la integridad de los resultados únicamente pueden ser inferidos inspeccionando los resultados. No obstante, estos últimos, si son apropiados, sólo pueden ser conocidos mediante el desarrollo de un experimento competente. Por lo que concluye que la réplica no podrá por sí sola fundamentar la veracidad de una teoría y siempre será inevitable un añadido no rigurosamente técnico. Un resultado experimental no basta por sí sólo para que la comunidad científica crea una cierta aserción. Para Latour (2001: 149), la ciencia, la comunidad científica y los resultados experimentales son afectados y modificados por los experimentos, estos traspasan la frontera del todo o nada. Un experimento no puede situarse exclusivamente en el laboratorio, en la literatura científica o en el debate entre científicos. Un experimento se constituye en una historia unida a un evento, es un acontecimiento, es un texto que describe un evento no textual, un texto que es analizado y discutido, si al final tiene éxito, traspasa la connotación de texto y se convierte en un experimento.

El problema epistemológico acerca de la relación de las representaciones científicas con la realidad se debe al olvido de las relaciones del extenso material obtenido con los procesos sociales, detrás de las representaciones acabadas[7]. A pesar de que existen múltiples formas de interpretación, éstas están limitadas mediante mecanismos sociales, retóricos, institucionales, entre otros, con la finalidad de deconstruir la idea de representación en cada caso en particular. Las explicaciones sociales del conocimiento científico son prioritarias al papel que desempeñan la lógica y la evidencia empírica. En concreto, se trata de describir el proceso de construcción de los hechos y explicarlo sociológicamente. “El contenido científico debe explicarse tanto como sea posible mediante el supuesto de que son los factores sociales, no los respectivos considerados técnicos, los que permite su generación y validación” (Lamo de Espinosa y otros 1994:548). La tensión de abordar el proceso en como los científicos hacen para representar, no permite ahondar sobre lo que posiblemente hacen las actividades representantes. Así, la representación y lo representado surgen, y se unen en el mismo proceso material del trabajo científico. Parece que estos estudios plantean un doble juego. Proceden en algunos casos como si excluyeran cualquier consideración de la epistemología de la representación y mostraran interés en las prácticas representativas a través de considerarlas un fenómeno social.

Hay algo contradictorio, según mi punto de vista, sobre esta manera de proceder. Primero, se hace un esfuerzo al deconstruir la noción de representación a través de estudios de casos prácticos. En segundo lugar, se desafía a los filósofos, pues los sociólogos tomaron la delantera frente al problema de la representación, pero hay una dificultad, pues en lugar de ir ahondando en la noción de representación, lo que hacen es mostrar en que va realmente la representación científica, buscando ampliar su concepto. Entonces, surge la pregunta ¿realmente los etnometodologos y otros estudiosos de CTS están confiando en una noción bastante tradicional de representación, la misma noción de la que ellos partieron para su discusión? Creo que sí, pues realmente no hay argumentos para demostrar lo contrario. Latour (2001: 34), por ejemplo, propone abandonar el modelo de núcleo/ contenido , para estructurar un esquema de cinco bucles ( instrumentos, colegas, aliados, público y los vínculos o nudos) que permitirán hacer una representación realista de la ciencia. Los vínculos y nudos ocupan los puntos de intersección entre los cuatro bucles restantes, estos servirán de referente conceptual pues permite conectarlos. La transformación en cada etapa de referencia puede representarse como un intercambio entre lo que se gana (amplificación) y lo que se pierde (reducción) en cada uno de los pasos en los que se generan información.

Frente a este panorama de la deconstrucción de las representaciones científicas, se recoge de los sociólogos que la ciencia es una actividad científica. La construcción de los hechos es “totalmente social” y esto queda implícito en el quehacer científico. De Hacking, se retoma la aproximación a una comprensión adecuada de las prácticas científicas y la ciencia entendida en su propio hacer, lo que los científicos van haciendo entre sí y con otros; construyendo en medio de objetos no humanos, situaciones históricas particulares, diseños de técnicas y formas de comunicación.

Los acuerdos colectivos, permiten consensos estructurales que se constituyen a partir de los discursos, los valores y las prácticas sociales que circulan en una sociedad. Actúan como reguladores de conductas por adhesión o rechazo. Se trata de algo cambiante, móvil, impreciso y contundente a la vez. Produce materialidad, es decir, produce efectos concretos sobre los sujetos y su vida de relación, así como sobre las realizaciones humanas en general. Esto conlleva a que las prácticas sociales son determinantes, ya que permite que la información sea creada y transformada.

De las anteriores propuestas conviene resaltar que mantienen un punto en común: la señalización de los espacios de laboratorio y de la experimentación como lugares de grandes posibilidades para la construcción de un conocimiento más crítico con relación a la ciencia y con la sociedad.

Naturaleza de las Representaciones Científicas

La tendencia desde los años ochenta frente a las representaciones ha sido tema de debate entre los realistas- quienes consideran que éstas son las que dan cuenta de la realidad- y los antirrealistas- para los cuales lo más importante es la posibilidad de predecir y producir sucesos-. Esto parece ser una discusión sin ganadores inminentes y esta diferencia seguirá contribuyendo al debate en filosofía de la ciencia.

Esta parte de la investigación hace énfasis en el acercamiento al concepto de las representaciones desde la óptica actual. Sí bien se puede dar una aproximación histórica, la revisión de las propuestas actuales conlleva a hacer un análisis sobre la naturaleza de las representaciones científicas y su papel en la filosofía de la ciencia y en las prácticas científicas.

La idea de abandonar estudios de casos y tratar de orientarse hacia una teoría de la representación ha sido asumida por Ibarra y Mormann (1997), le apuestan a la noción de la representación, tomando como base la idea que la ciencia parte de la representación de objetos por medio de modelos, existiendo una “relación preservadora de estructuras”, cuyo significado está mediado por la intencionalidad del agente que la realiza. Proponen que la idea del carácter representacional de la ciencia está en relación directa con las principales formas “identificables en las prácticas representacionales de la ciencia” (Ibarra y Mormann 2001: 4), que se pueden clasificar como:

1. La representación como isomorfía,

2. La representación como sustitución,

3. La representación como homomorfía,

4. La representación como homología.

El primer tipo de representación, como isomorfía, se caracteriza por la necesidad de que exista una semejanza entre los dos objetos de la representación. En este momento no desempeña ningún papel importante en la práctica científica y se menciona sólo porque la clasificación quede completa. Copias de mapas, planos y gráficas son ejemplos clásicos de este tipo de representación.

Históricamente, frente a la representación como sustitución, se puede nombrar a Aristóteles como gestor de esta postura, quién toma lo semejante a algo, no como semejante, sino como aquello a lo que se asemeja. Esta concepción ha sufrido cambios, como lo fue en la Edad Media, en donde se asumió como medio para acceder al conocimiento y no el fin. Se presenta en términos de ejemplos, como en el caso del embajador de un país que puede representarlo en una conferencia; un abogado que representa a su cliente o el papel del apoderado de un menor. Los números y otras magnitudes matemáticas “funcionan como sustitutos vicariales de entidades empíricas de diverso tipo” (Ibarra y Mormann 2001: 6). Por su parte, la representación como homomorfía corresponde a la concepción de la representación “como aplicación preservadora de estructura”, entendidas como representaciones que conservan las formas. Por último, la representación como homología se caracteriza como aquel tipo de representación que no depende ni de la semejanza objetual ni de la estructural, sino aquellas que conservan la lógica. Esta concepción se introduce a partir de una idea de Hertz. Los autores pretenden mostrar que las representaciones científicas no son generalmente de tipo homomórfico, es decir, del tipo de representación que, según ellos, ha sido el más estudiado en la filosofía de la ciencia, sino de tipo homológico, en estos se contaran procesos que confían en complejos procesos que pueden ser estadístico-computacionales.

La idea de la representación como homología puede derivarse de la descripción que hace Hertz de la actividad científica como la producción de una simetría entre “las consecuencias naturalmente necesarias” y “las consecuencias intelectualmente necesarias” de sus representaciones. Esta simetría se ilustra en el siguiente diagrama:

La idea de los autores es la siguiente:

La parte izquierda del diagrama, A −

→ A∗ puede interpretarse como un proceso empírico en el que se pasa del estado A al estado A∗ a través de tA. Este paso se representaría por un proceso teórico consistente en el paso de B a B∗ por tB, tal que tB es una relación lógica [. . . ] entre B y B∗ que corresponde a la relación tA “naturalmente necesaria” en el sentido que el diagrama conmuta (Ibarra y Mormann 2001: 30)

Otro aspecto relevante es que, en la ciencia, todas las representaciones forman una compleja red representacional que está constituida por diversos tipos de combinaciones. Por ejemplo, un objeto o proceso puede generar diferentes representaciones o una representación puede valer para diferentes objetos, procesos o representaciones. Esta estructura reticular de las representaciones se podría capturar por medio de la estructura combinatoria- asociativa- de los diagramas.

Usando estos supuestos no les es difícil mostrar que la teoría matemática de las categorías es, de hecho, una teoría de la combinación de representaciones posibles. Una vez que este punto ha sido establecido, pasan a mostrar la significación epistemológica de la teoría de categorías, que es concebida como una teoría combinatoria general de las representaciones.

La búsqueda de una teoría de la representación es lograr “la identidad característica de una teoría”.

(…) no reside en la base empírica dada ni en los conceptos que fijan su marco conceptual, sino en el espacio inducido, por así decir, por la relación de representación, esto es, en el encaje estructural concebido no referencialmente como singularización de los modelos estándar de la teoría, por ejemplo, sino en su sentido más estrictamente funcional, como aplicación preservadora de estructuras, y extensible a una variedad de marcos teóricos posibles en los que fija su significación (Ibarra y Mormann 1997: 10).

La tesis de que hay una teoría filosófica general de las representaciones que “capta las propiedades esenciales de las representaciones” mejor que otras propuestas parte del supuesto, ciertamente controversial, de que existen tales propiedades esenciales de las representaciones. Toda una serie de investigaciones en estudios sobre la ciencia sugiere que no hay tal teoría general de la representación, y que la única manera fructífera de estudiar el tema de la representación es a través de un estudio de casos y de propuestas de clasificación de diferentes tipos de representación que puedan servir para entender mejor como crece el conocimiento. Esto no le quita interés filosófico al tema de la representación, pero lo sitúa en un espacio de discusión que no es el que los autores proponen. Sigue siendo filosóficamente interesante entender la manera en que determinados tipos de representación están asociados con diferentes tipos de conocimiento.

La propuesta de Ibarra y Mormann (1997) ha sido criticada por algunos autores como Martínez, (2001), quien considera que este tipo de enfoque formalista del tema de la representación tiene serias limitaciones. Partiendo de la historia muestra que no queda claro qué tipo de clasificación están ofreciendo. Pero, según ellos, “se trata de una clasificación motivada por razones esencialmente metodológicas, pero nunca queda claro cuales son esas razones, más bien parece que las motivaciones son metafísicas” (Martínez, 2001: 75-95).

A un nivel práctico, dado la diversidad de las representaciones que se usan y la complejidad de sus prácticas, parece claro que el concepto general de representación no ayuda mucho a explicar qué tipo de cosa es y como se constituye.

Por otro lado, Suárez (2003a: 225-244), indica que las fuentes de representaciones científicas pueden ser objetos físicos concretos- sistemas, modelos, diagramas, imágenes o ecuaciones- para los posibles blancos. Puede haber una gran variedad de medios, ya que la representación hace su trabajo a su modo: el isomorfismo y la similitud son simplemente dos comunes pero, hay otros como la ejemplificación, la convención y la verdad. Además, los medios de representación no son precisamente transparentes unos respecto a los otros, es decir, ninguna fuente lleva sus medios de representación debajo de la camisa.

Suárez, se opone a toda propuesta que apunte a una teoría de la representación centrada en el isomorfismo y la similitud, y frente a esto plantea cinco argumentos. El primer argumento es la observación empírica simple, pues ni la similitud ni el isomorfismo pueden aplicarse a la variedad de dispositivos de representación que se usan en la práctica de la ciencia. El segundo argumento es que estos no cumplen algunas de las propiedades lógicas formales de la representación, como la propiedad simétrica, reflexiva y la relación transitiva. El tercer argumento es que no permiten acercamientos a la falsedad o la representación inexacta. El cuarto el argumento es que no son necesarios para la representación, ya que fallan en algunos casos de representación exitosa. El quinto y último argumento es que no suficientes para la representación, puesto que omiten esencialmente la direccionalidad de la representación.

La intencionalidad del agente, su competencia y su capacidad para permitir el razonamiento serán la clave en el proceso de representación. A sólo representa a B si (i) la fuerza representacional de A apunta hacia B, y (ii) A les permite a unos agentes informados competentes plantear las inferencias específicas respecto un B. Así, los modelos se satisfacen por inferencias de sus blancos., pues es factor importante la actividad intencional de los usuarios de la representación, negando que la relación de representación solo pueda tener en cuenta las propiedades respectivas del vehículo representativo y su objeto designado.

La concepción de la representación es inferencial, por lo tanto todo tipo de representaciones mantiene una serie de relaciones que tienen un carácter a producir nuevas representaciones, o a generar acciones permitiendo a los agentes disponer de nuevos elementos para su interpretación. Zamora (2005:199), expresa frente a la interpretación inferencialista, que para entender un significado, es primordial presentar razones con el fin de buscar la aceptación, de tal manera que se aceptaran las consecuencias producto de esta. Esto lo autoriza para llevar a cabo determinadas afirmaciones. “Las inferencias no son únicamente internas al lenguaje de ciertas afirmaciones no se seguirán determinadas acciones y, a sí mismo algunas afirmaciones no se seguirán de otras, sino más bien de ciertas percepciones”. El carácter inferencial permite abrir caminos a la mediación de los modelos, pues el uso de este presupone la aceptación previa, entendida inferencialmente, así este no puede usarse salvo si se acepta todas las consecuencias que se derivan de este. Es la capacidad de los modelos como generadores de inferencia que les permite usarlos como representaciones.

Estas son dos aproximaciones de la diversidad de maneras de reconocer la complejidad de las prácticas representacionales. El propósito de postular una teoría general de las representaciones que existen en la ciencia es una tarea compleja que apenas comienza y sobre la cual no hay acuerdos, pues algunos consideran que más que una teoría debería estudiarse el tema de la representación a través de un estudio de casos y de propuestas de clasificación de diferentes tipos de representación, que puedan servir para entender mejor como surge el conocimiento.

La consideración de un agente como elemento fundamental en la teoría de las representaciones consideradas en este apartado, lleva a que sea este quien tenga la capacidad de generar los medios representacionales (modelos, diagramas, gráficos) que permitirán lograr un acercamiento a lo que se pretende representar, pues la consecución de información del medio, la búsqueda de medios representacionales y su comunicación, son las tareas de la actividad científica, un buen acercamiento a ellas, en última instancia permitirán la generación de conocimiento, justificando su papel epistemológico[8].

¿Qué representan los Modelos Científicos?

Mirando la representación desde el ángulo de los modelos científicos, se enfatiza en los métodos, los ingredientes y los dispositivos representativos que se necesitan, por eso se considera valioso revisar las propuestas de Hughes (1997), Giere (2004), Morrison- Morgan (2004) y Knuuttila Tarja (2005). Los Modelos no sólo funcionan como herramientas y generadores de inferencia, sino en derecho propio, como objetos de investigación.

Hughes (1997:325-336) llama representación a las “construcciones teóricas, modelos y la relación entre ellas (…) pero no todas las representaciones sobre el mundo son modelos teóricos”. Plantea tres componentes DDI- designación-demostración-interpretación- que corresponde a diferentes aspectos de la práctica científica. Según Hughes, la representación científica puede ser analizada útilmente como una noción de tres partes, que incluye la designación física del sistema y sus propiedades por medio de elementos del modelo, incluyendo las ecuaciones, los diagramas, etc; la demostración de las consecuencias dinámicas del modelo y la interpretación de estas consecuencias.

La teoría de representación que Hughes defiende tiene los elementos de “la designación” -los elementos del modelo, por ejemplo, denotan los fenómenos- y “la demostración” - usa el modelo para conseguir un resultado- y “la interpretación” - el resultado se interpreta físicamente-. DDI no proporciona requisitos y condiciones suficientes para cuando una representación tiene lugar; más bien, Hughes está “haciendo una modesta sugerencia, pues si examinamos un modelo teórico con estas tres actividades en la mente, podremos lograr alguna visión en el tipo de representación que proporciona”. Sin embargo, esto no es considerado por Súarez, quien afirma que el modelo DDI de Hughes no puede constituirse en una teoría general de la representación, ya que la denotación, la demostración y la interpretación son las condiciones necesarias pero no suficientes. “Para Hughes, la representación involucra la demostración esencialmente, y por lo tanto requiere llevar a cabo las inferencias sobre la fuente por parte de un agente” (Suarez 2004: 767- 780), Esto permite abrir el debate sobre otros aspectos diferentes a la similitud y al isomorfismo presentes en las teorías de representación.

Algunos filósofos de las ciencias han asumido el tema de las representaciones considerando que los modelos científicos pueden asumir el papel fundamental de esta, pues estos se han convertido en verdaderos ensambles heterogéneos que con sus diferentes roles permiten aproximarse al conocimiento. A pesar de las diferentes orientaciones filosóficas es posible reconocer en ellos sus posturas acerca de lo que se asume como modelo.

La propuesta de Giere (1992) sobre la representación científica ha contribuido al desarrollo de la ciencia cognoscitiva en las últimas décadas, según los expresa se debe “usar los conceptos y métodos de las ciencias cognitivas para estudiar la propia ciencia” (Giere 2004:742-752). Se parte de que el ser humano, gracias a su evolución, tiene capacidades cognitivas como la percepción, la memoria, el control locomotor, la imaginación y el lenguaje, los cuales le permiten interactuar con el ambiente y, estas mismas capacidades le han permitido al científico además de interactuar, construir la ciencia moderna. Las ciencias cognitivas aportan los recursos más poderosos y prometedores para estudiar la ciencia como una empresa cognitiva y a los científicos como agentes cognitivos.

El tema central de la discusión son las representaciones, que “son mapas internos del mundo externo” (Giere 1992:10). Con mapas internos se refiere a las creencias, modelos y teorías. Caracteriza cada uno de estos medios que permiten las representaciones. El concepto fundamental en la práctica representacional está fundamentado en los modelos. Presentar una teoría es especificar a una familia de estructuras, modelos y, después se debe especificar una cierta parte de esos modelos como candidatos para la representación directa de los fenómenos. Giere niega que la relación entre el modelo y un sistema real no es principalmente el de la verdad, correspondencia o isomorfismo sino de similitud. No muestra interés por definir la noción de similitud, pues, en su opinión, las ciencias cognoscitivas evidencian que “la cognición humana y la percepción operan con base a alguna clase de similitud métrica, los eslabones entre los modelos son más bien las relaciones de similitud que las conexiones lógicas. Los modelos son objetos abstractos construidos en conformidad con apropiados principios generales y condiciones específicas” (Giere 2004:747). Poder usar un modelo para representar algunos aspectos del mundo permite escoger de forma pertinente los rasgos similares. La existencia de las similitudes específicas hace posible el uso del modelo para representar el sistema real de esta manera. Sin embargo, esto no impide a los modelos proporcionar intuiciones profundas y útiles acerca del funcionamiento del mundo natural.

La ciencia proporciona modelos de la realidad que poseen varios grados de alcance y precisión. La clase de modelos científicos incluye modelos físicos a escala y representaciones por diagramas, pero los modelos de mayor interés son los modelos teóricos. Estos son objetos abstractos, entidades imaginarias cuya estructura puede ser ó no similar a aspectos y procesos en el mundo real. Los científicos hablan corrientemente de la correspondencia entre sus modelos y el mundo.

Desarrolla su visión de modelos basado en la mecánica clásica presentada en los libros de texto avanzados, teniendo en cuenta que los estudios fundacionales sobre los cuáles se ocupan algunos filósofos, “no han influido en la manera como los científicos enseñan, aprenden o entienden la ciencia” (Giere 1992:27). En los textos se presentan estudios de casos, como el del oscilador armónico que posibilitan la interpretación y la identificación.

Por ejemplo, en la fórmula F = -kx, podemos interpretar x, como el desplazamiento de una partícula respecto de su posición de reposo. Al aplicar la fórmula al estudio de una cierta masa unida a un resorte, identificamos x como el desplazamiento de esta masa en particular respecto a su posición de equilibrio (Giere 1992:90).

Así, el “oscilador lineal” no es un solo modelo con versiones específicas diferentes sino un racimo de modelos de variantes grados de especificidad. Encuentra como norma en los libros de texto “una población de modelos que consisten en familias relacionadas de modelos” (Giere 1992:104). Los modelos como tales no se constituyen en verdad o falsedad respecto a el mundo; el papel de la teoría es más bien exigir un “el ataque bueno entre los modelos y algunos tipos importantes de sistemas reales” (Giere 1992:107). Por consiguiente, sugiere que una teoría comprende dos elementos: (1) una población de modelos, y (2) varias hipótesis que unen aquéllos modelos con los sistemas en el mundo real. Como una consecuencia para un científico la teoría no resulta ser una entidad bien definida. Nada en la estructura de cualquier modelo podría determinar si pertenece a una familia dada de modelos o no. El juez es la comunidad científica quien determina si el parecido es suficiente. Esto permite plantear la relación triádica donde las decisiones por parte de los científicos permiten aceptar los modelos como las mejores representaciones de la realidad. “Los científicos son agentes intencionales con metas y propósitos específicos” (Giere 2004:743), los términos de la representación estarían dados por la forma “S usa X para representar W para propósitos P” (Giere 2004:743), donde S puede ser un científico individual, un grupo de científicos o una comunidad científica, W es un aspecto del mundo real y X son los modelos[9].

La idea de que los modelos son entidades abstractas corresponde con la idea de “los modelos mentales”, propuesta en la ciencia cognoscitiva algunos hace años. Pero, también persiste la idea de que los modelos deben ser cosas materialmente existentes de alguna clase, ellos funcionan como las herramientas centrales de la ciencia y median entre las personas y otros artefactos. En esta concepción se enmarca lo expuesto por Morrison y Morgan, quienes proponen que se debe investigar los modelos usados en la ciencia para entender el tipo de entidades, qué son y cómo funcionan. Atribuyen la importancia de los modelos a los procesos de construcción y a la manipulación en lugar de enfocarse unilateralmente en la representación. Enfatizan en que se aprenden de los modelos construyéndolos y manipulándolos, por lo tanto, son algo más concreto que una simple idea conceptual. Estos son, en parte, los mediadores independientes entre la teoría y los datos. Por ejemplo, para hacer una economía matemática, el economista no solo necesita del lenguaje, de los términos ó las fórmulas matemáticas, sino además imaginar un mundo matemáticamente descrito, dentro del cual sus ideas económicas puedan expresarse. La economía confió en los procesos de imaginación e imagen que hicieron los matemáticos, pero la matematización de la economía permitió concebir un cambio en cómo los economistas entienden y perciben los fenómenos económicos.

El acto de representación involucra la visualización directa del mundo económico en los símbolos matemáticos y otros formularios de designación no-verbal para crear un nuevo mundo en el modelo. Llegar a la versión recientemente hecha del mundo económico requiere la imaginación sobre cómo representar el mundo y hacer una imagen de él en un modelo. Es por eso que la representación se vuelve un complicado proceso productivo e interpretativo.

Siguiendo la misma línea de trabajo se encuentra la propuesta de Knuuttila (2005), quién plantea la concepción de modelos como artefactos epistémicos, lo cual se resume en los siguientes puntos: i) los modelos son artefactos humanos, que se usan para actuar recíprocamente con el mundo en lugar de usarse para representarlo; ii) más que construcciones teóricas abstractas, se conciben como entidades que se materializan en algunos medios de comunicación; iii) el valor epistémico de los modelos sobrepasa pretenciosamente de su dimensión material y explica el porqué los modelos tienen otras funciones epistémicas además de la representar el mundo; iv) la función representacional de los modelos no debe aproximarse a términos representacionalistas comunes, y v) la representación es la actividad que cuenta tanto con el medio específico de la señal-vehículo material y el proceso intencional de relacionar la señal-vehículo a su objeto, denominándose el pragmatismo triádico.

El acercamiento a los modelos debe hacerse desde su valor productivo donde su quehacer y posibilidad de experimentación le dan un valor epistémico. El uso y los puntos de vista productivos le permiten acercarse a lo que podría llamarse representación, pero se hace necesario superar ese concepto hacia una función no representacionalista.

La concepción semántica de las teorías científicas expresa que los modelos semánticos o meta-matemáticos de la teoría proporcionan los elementos suficientes para abordar la relación entre modelos y el mundo, ya sea a través de predicados teóricos, uso del lenguaje matemático ó las ciencias de la comunicación. Sin embargo, no hay un consenso frente a la concepción de modelos. Se encuentran posiciones en las cuales los modelos son asumidos como abstracciones de la teoría o clase de modelos (las diferentes proposiciones, las frases, etc.) que nos indican una concepción de la realidad o aspectos de esta. Los modelos están en el mundo en algún sentido y sobre estos se obtienen rendimientos epistemológicos distintos, pues se acude a instancias de isomorfismo entre la teoría y el mundo. Ciertamente es correcto decir que planean representar el mundo, que son entidades representativas.

Cómo utilizan los científicos los modelos?

El hecho significativo de la representación científica tiene sus cimientos en la práctica de los científicos por eso se hace necesario entrar en sus propias concepciones filosóficas acerca de los modelos como representación. Retomando a Knuuttila (2005), el valor epistémico de los modelos toma relevancia partir de su valor productivo en el quehacer y la experimentación. La práctica, uso y producción les permite acercarse a lo que se podría llamar representación. La filosofía de la ciencia propone una discusión acerca de la formulación de los modelos en la práctica científica pero se hace necesario preguntarse cómo estas diversas propuestas funcionan en la ciencia, y es cuando es interesante adentrarse en el discurso científico para comparar como ellos conciben los modelos en su práctica.

Este referente es interesante en la medida que permite visualizar el camino trazado por los hombres de ciencia en la materialización de sus propuestas de modelos.

De Gennes Pierre-Gilles, Premio Nobel de Física en 1991, mostró cómo pueden usarse analogías simples para entender sistemas complejos como los cristales líquidos y polímeros. Estos materiales son al mismo tiempo sólidos y líquidos. Él explicó las propiedades de los materiales sobre las transiciones de fase orden-desorden en sistemas más simples. De Gennes descubrió que aunque las transiciones de fase en materiales diferentes dan lugar a fenómenos extensamente diferentes, estos son gobernados por parámetros diferentes, como temperatura, la concentración, campo magnético o eléctrico, que pueden describirse de una manera muy general. Si la estructura es un cristal líquido, ferromagnético, superconductor o polímero, pueden identificarse rasgos universales y pueden ser explicados por leyes de escala simple. “¿Qué queremos decir nosotros por materia suave? Los americanos prefieren llamarlo “fluido complejo” .Aunque parezca un nombre bastante extraño y poco atractivo trae consigo dos rasgos mayores:

i) la Complejidad. Podemos decir que la biología moderna, ha procedido desde el estudio de modelos simples (bacterias) a organismos multicelulares complejos (plantas, invertebrado, los vertebrados...). Semejante a la explosión de física atómica en el primero la mitad de este siglo, uno de los aspectos superados es la materia suave, basada en los polímeros, cristales líquidos y granos coloidales.

ii) la flexibilidad. Explica esto a través de un experimento del polímero temprano, este es el hecho conocido por los indios del Amazonas: ellos recogen la savia del árbol del hevea, lo ponen en su pie, lo dejan secar durante un tiempo corto y luego tienen una bota. Desde un punto de vista microscópico, la explicación de este hecho, es la estructura en cadenas de polímeros independientes, flexibles. El oxígeno del aire une los puentes entre las cadenas, y esto conlleva a un espectacular cambio: se cambia de líquido a una estructura de la red que puede resistir tensión - lo que nosotros llamamos un caucho (en francés: el caoutchouc, una trascripción directa de la palabra nativa). Lo que está mostrando este experimento, es el hecho que una acción química ha inducido un cambio drástico en las propiedades mecánicas: un rasgo típico de la materia suave[10].

El valor epistémico del modelo planteado está en la intencionalidad del científico pues no basta solo con el modelo teórico y el modelo empírico y la coherencia entre ellos sino que entra en juego la inferencia a buscar una explicación que permita abordar el hecho que se estudia, su extensiva aplicación a otros campos y la generación de nuevas explicaciones permiten entender su valor dentro del campo científico

Según Prigogine (1977), desde el campo de la ciencia, la idea de las leyes de la naturaleza ha perneado el concepto de la ciencia occidental, tanto así que se justifica desde un carácter finalista, “pareciera que la naturaleza está obligada a cumplir ciertas reglas”. Esto último conllevo al desarrollo de la ciencia moderna, pues las explicaciones estaban dadas en relación con las leyes de la naturaleza. Según lo expresa Poincaré, al hacer referencia al éxito de la teoría cinética, los modelos se formulan a partir de las leyes, se constituyen en los pilares de la explicación y, en algunos casos, permiten formular teorías. “Tal vez sea la teoría cinética de los gases la que se desarrollará y servirá de modelo a las otras…La ley física cobraría entonces un aspecto totalmente nuevo… poseería el carácter de una ley estadística” (citado por Prigogine 1977:31). Las preguntas sobre la utilidad del estado representacional llevan a un pragmatismo y sirven de ayuda pragmática al reconocimiento de una relación representacional, que es constituido por otro.

Cuando se usan modelos se buscan ámbitos de explicaciones posibles, que estarían dadas por las propiedades del modelo, es un “modo de presentar las estructuras que posiblemente tengan las materias” (Hanson 1997). El premio Nobel de Física del año 1997, Anderson, Philip, expresó en la ceremonia en Estocolmo que

El arte de la construcción de modelos es la exclusión de partes reales pero insignificantes del problema…la construcción de modelos comporta peligros para el constructor y para el lector, el constructor puede pasar por alto algo que sea realmente de importancia, mientras que el lector producto de una computación realmente precisa puede tomar literalmente un modelo esquemático, cuya meta principal sea la demostración de una posibilidad (citado por Judson 1984:48 ).

En la teoría de Anderson, físico del estado sólido de los Laboratorios Telefónicos Bell, el modelo se expresa como un conjunto de ecuaciones, apenas una página de relaciones simbolizadas. Galison (2004) intenta mostrar como Einstein y Poincaré buscan especies de modelos útiles para su trabajo a través de los relojes y de los mapas respectivamente. La formulación de modelos es, por tanto, indispensable en el trabajo científico. Los tipos de modelos pueden variar de ser un conjunto de ecuaciones a un mapa o, un conjunto de relojes pueden pasar a ser mecanismos más complejos, donde está presente todo el proceso creativo de sus creadores.

El juego incesante entre la predicción y la corrección del modelo es la característica principal de toda teorización en la ciencia. Los modelos complejos permiten teorizaciones, como en el caso de Linus, quién en 1948 presentó un modelo que compilaba los trabajos realizados en los últimos diez años acerca de la naturaleza de la vida. Formuló la estructura de las proteínas como cadenas de enlace enroscados, llamada hélice alfa y, a partir de la utilización de perillas y bolas de colores brillantes, representó los átomos que funcionaban casi como una computadora análoga para prevenir errores. Las formas y tamaños de las perillas eran exactas, hasta una milésima de centímetro para representar con precisión los tamaños a los cuales los átomos empiezan a disponerse de otras maneras en las diversas combinaciones; las uniones, a través de los cuales encajan, tenían ángulos y distancias correctas. Frente a la pregunta ¿es el modelado una forma de construir teorías? Respondió: “Sí, así lo creo (…) la construcción de un modelo puede representar el desarrollo de una teoría y con un modelo la teoría será precisa”(citado por Judson 1984:65 ). Observando los detalles del modelo, éste no daría respuesta de verdad o falsedad. Simplemente se ajusta a las necesidades de explicación del científico. Si la representación es una relación, entonces un modelo no puede representar el ADN a menos que éste exista No hay ninguna razón para temer que solamente el estado aproximado de un modelo imponga su capacidad de representar.

Schrödinger( 175:136 ) expresó :

Nunca podemos decir qué es en realidad o qué ocurre en realidad, sino solo lo que es observable en cada caso concreto, ¿debemos contentarnos con esto como algo permanente? En principio, sí. Está muy lejos de ser nuevo afirmar que, en principio, la meta última de la ciencia exacta debe limitarse a la descripción de lo realmente observable. La respuesta es sólo si, en adelante- como hasta ahora-, habremos de renunciar a conectar esta descripción con una hipótesis definitiva sobre la verdadera estructura del universo. Existe una difundida tendencia a insistir en esta renuncia. Pero yo creo que esto es tomar las cosas a la ligera”

De esta manera se llega al punto de encuentro con los filósofos, quienes discuten sí las teorías como representaciones y éstas como modelos se constituyen en las piezas claves de la investigación científica. Según Olivé ( ), “una teoría aproximadamente verdadera, es una teoría que a través de sus modelos ofrece una descripción correcta, o adecuada, pero siempre parcial de sistemas reales, de su estructura y funcionamiento”

Las concepciones acerca de los modelos por parte de los científicos son tan variadas que las técnicas y medios comunicacionales se confunden con la concepción de modelo que subyace pero lo interesante en esta revisión es encontrar puntos de encuentro entre agentes diferentes (en este caso filósofos y científicos), que tienen formaciones, e intereses diferentes pero que encuentran en la representación un punto de discusión.

La formulación y rivalidad de los modelos

Los textos de Física se constituyen en promotores de modelos que cumplen determinadas funciones de acuerdo a las aplicaciones que se les quiera dar, cumpliendo la intencionalidad del agente. Los variados vehículos de representación son usados en las escenas científicas (los modelos, las ecuaciones, las construcciones, los dibujos, etc.) y como estos representan sus blancos (la conducta de gases ideales, las evoluciones de estado cuántico, los puentes) en virtud de los estados mentales de su constructores ó usuarios. Por ejemplo, un dibujo representa un puente, porque el fabricante del dibujo estipula que lo hace, y hace creer a su público, la creencia que lo hace, responde de forma alguna a los propósitos personales, los puntos de vista o intereses de los investigadores.

La percepción de los modelos como mediadores entre las teorías, fenómenos y datos, nos permiten ubicarlos en la concepción práctica de modelos considerándolos como los mediadores independientes entre la teoría y los datos, su papel como artefacto epistemológico le permiten acceder al conocimiento de muchas maneras, más que ser los representantes directos; la consideración como objetos y herramientas de investigación, permite a través de los medios comunicacionales, la búsqueda del carácter inferencial del modelo, y esto nos lleva a buscar un ejemplo desde la física cuántica que dé razón de estos aspectos.

Los libros de texto se han constituido en la principal fuente de acercamiento al conocimiento científico, tal como lo expresa Giere (1992:86) “si deseamos enterarnos de lo que es una teoría desde la perspectiva de los científicos que la usan, una manera de proceder es examinar los libros de texto de los cuales aprendieron la mayor parte de lo que saben acerca de esa teoría”.

La tendencia a lo largo de los textos de mecánica cuántica ha favorecido la propuesta de Schrödinger frente a la de Heisenberg. Históricamente, la formulación de la mecánica matricial tuvo lugar en 1925 con Werner Heisenberg, Max Born y Pascual Jordan, a partir de los conceptos de energía y probabilidad y, en 1926, Schrödinger fórmuló matemáticamente la mecánica cuántica en términos de ecuaciones diferenciales, aunque hizo una equivalencia parcial con la matricial. Las ecuaciones diferenciales se constituyen en los instrumentos favoritos de la física, ya que permiten plantear modelos para la comprensión de la materia: las moléculas pueden ser tratadas como si fuesen ondas[11].

Un modelo ondulatorio de la materia era una guía adecuada para construir una teoría, la tarea era encontrar una ecuación de onda para las ondas materiales.

Cuando aplicó la ecuación a varios problemas de la teoría cuántica que servían de piedras de toque, el oscilador armónico, el rotador simple, el rotador vibracional y el átomo de hidrógeno- algunas de las aplicaciones que hacía poco emplearan Heisenberg, Born, Jordan y Pauli para verificar la nueva mecánica de matrices-, obtuvo precisamente los espectros de energía requeridos. Incluso obtuvo el estado energético fundamental semientero, en vez de nulo, para el oscilador armónico: resultado que Heisenberg había exibido orgullosamente varios meses antes, cuando introdujo su nueva cinemática cuántica ( Wesel 1990:234)

Al analizar esta decisión desde los modelos productores propuestos por Knuuttila, se debe hacer énfasis en los métodos, los ingredientes y los dispositivos representativos que permitieron que la propuesta de Schrödinger se impusiera a la Heisenberg en los libros de texto. Por un lado, se debe estudiar los artefactos y los modelos; sus interacciones específicas y sus producciones, así como los medios de comunicación, métodos y los conocimientos. Por otro lado, se debe estudiar cómo la relación representativa entre la señal-vehículo y su objeto es logrado. El ejemplo tomado se centra en los procesos de construcción y controversia en lugar de enfocarse unilateralmente en la representación.

Dos importantes disciplinas matemáticas son esenciales para entender la mecánica cuántica. Una de ellas es el álgebra lineal -matrices y determinantes- y la otra son las ecuaciones diferenciales. Es considerado que los dos modelos matemáticos, aunque son diferentes pueden ser equivalentes, porque ellos pueden transformarse entre si (aunque no recíprocamente)[12].

El trabajo de Heisenberg en la mecánica matricial es de una naturaleza especializada. Hoy día el álgebra lineal es un asunto de los primeros cursos de matemáticas de la universidad pero, en 1925, era una rama desconocida para los físicos. Fue publicada en 1924 por Hilbert- Courant en el libro “Métodos de Física- Matemática” y aprovechada por Börh, Heisenberg y Jordán para la formulación rigurosa de la mecánica de matrices[13].

Esto nos lleva a preguntarnos por el papel de las matemáticas en la representación, el protagonismo dado en otras concepciones diferente a los modelos como mediadores, la ubican en una posición privilegiada denominándola “el lenguaje de la física”, tratándola como monismo representacional por excelencia en las ciencias físicas, contrapuesto a esto es el pluralismo representacional que presupone la intencionalidad del agente en los procesos que lleva a cabo. [14]

En la formulación clásica, el movimiento de una sola partícula de masa m es determinado por las coordenadas de posición -x,y,z- y por los componentes del momento -px,py,pz-: la cantidad de movimiento está definida como el producto de la masa m de la partícula y sus componentes de velocidad -vx,vy,vz-. Así,

px = mvx, etc.

px es llamada conjugada de la coordenada x, py de y, pz de z. La anterior descripción puede generalizarse a un sistema de muchas partículas introduciendo un juego de coordenadas generalizadas qi y los momentos conjugados pi. Estas generalizaciones de coordenadas y momentos constituyen la base para la formulación de mecánica de matrices.

En la mecánica matricial, las coordenadas qi y los momentos pi se representan simbólicamente por matrices. Por simplicidad, se considera el movimiento en una sola dimensión. La regla de cuantización requiere que la diferencia entre el productos de dos matriz p. q y q. p sea igual a la matriz identidad I multiplicado por el factor h/2 Π. Este último término, se define como ħ = h/2 Π.

La regla de cuantización podría escribirse por consiguiente como,

p .q – q . p = ħ I

Para determinar los estados estacionarios de un sistema, es necesario primero expresar la energía del sistema como una función de la coordenada q y del momentum p. Esta función es conocida como la función Hamiltoniana H del sistema. La matriz H que representa el Hamiltoniano es obtenida sustituyendo las matrices q y p en la expresión analítica para el Hamiltoniano.

Los estados estacionarios del sistema son derivados, identificando las expresiones de la matriz q y p, asociados en la diagonal de H, es decir, una matriz H dónde todos los elementos no diagonales son cero. El procedimiento es bien definido, lógico y consistente y, fue aplicado para derivar con éxito los estados estacionarios del oscilador armónico. Sin embargo, la matemática que es requerida para las aplicaciones de otros sistemas es sumamente engorrosa y, por consiguiente, el uso práctico de la mecánica matricial fue limitado.

La intencionalidad del agente en la representación, nos lleva a retomar lo planteado por Zamora (2005:162), quien expresa que hay una cuádruple analogía entre el sistema científico y el sistema económico, el valor científico dependerá de los factores objetivos y subjetivos, en este caso vale la pena resaltar este factor pues las interpretaciones inferenciales de cada científico como agente intencional, le permiten obtener valores epistémicos a sus modelos, lo cual se traduce en una distribución de valoraciones. La valoración epistémico llegará a una situación de equilibrio cuando en la confrontación de los modelos de representación no haya un incentivo mayor del uno frente al otro, poniendo en juego la autoridad cognitiva que tiene que ver con las relaciones de recursos, productividad, de los modelos en competencia, y las normas de la comunidad científica con las que se encuentran los modelos en competencia, esta propuesta permite ver la intencionalidad del agente en los modelos mediadores, desde una perspectiva económica.

Heisenberg pensaba que la descripción mecánica cuántica de sistemas atómicos debería centrarse solo en las cantidades físicas notables. Por consiguiente, no deben usarse las órbitas y velocidad adquirida de los electrones dentro del átomo porque no pueden observarse. La teoría debe partir de los datos experimentales que pueden derivarse de los espectros atómicos. Las valoraciones epistémicos del modelo de Heisenberg, nos indican que ante todo buscaba un modelo centrado en identidades no observables, como lo propone Hacking (1992), su existencia debe ser inferida a partir de la evidencia observacional, jugando un papel importante las prácticas científicas.

Cada línea en el espectro atómico es determinada por su frecuencia v y por su intensidad. Este último es relacionado con otra cantidad física notable denominada momento de la transición. La transición espectral entre dos estados estacionarios n y m es por consiguiente determinado por el v- n,m de frecuencia- y por el x- n,m de momento de transición-. Heisenberg propuso un modelo matemático en el que se presentaban las cantidades físicas por juegos que contenían el x- n de momentos de transición, m- además del tiempo, dependiente de las condiciones de frecuencia[15].

Existe una anécdota interesante y divertida relacionada con el descubrimiento de Mecánica Matricial, expuesta por Hameka (2004:13). Cuando Heisenberg mostró su obra a Born, éste dijo no saber nada sobre matrices pues no se acordó que había aprendido un poco de álgebra lineal cuando era estudiante. Recurrieron a Hilbert para obtener la ayuda. Durante la reunión, Hilbert mencionó, entre otras cosas, que las matrices juegan un papel importante en la solución de ecuaciones diferenciales en condiciones límite. Estas condiciones especiales fueron las que usó Schrödinger para demostrar la equivalencia de la mecánica matricial y la formulación diferencial. Después, Hilbert dijo a algunos de sus amigos entre risas que Born y Heisenberg podían haber descubierto la ecuación de Schrödinger antes, si hubieran puesto más atención a lo que les estaba diciendo. Si esto es verdadero o no, es una buena anécdota. Para la mayoría de los estudiosos de la mecánica cuántica, la ecuación de Schrödinger es más accesible que la mecánica de matrices[16].

La idea motivadora para Schröndinger en la búsqueda de una ecuación había sido que cada una de las partículas era en realidad una onda, y que ésta determinaría las características físicas de dicha onda. Se considera al átomo como un sistema de vibraciones, en lugar de un sistema mecánico. Sin embargo, en la ecuación encontrada, los dispositivos representativos estaban lejos de satisfacer las condiciones de las ondas físicas y en este punto solo quedaban dos caminos “o rechazar la nueva ecuación y seguir buscando un modo de describir las supuestas ondas de la materia, o abandonar su plan originario de describir ondas materiales y desarrollar una teoría de la materia basada en la nueva ecuación”(Hameka 2004:15). Sobre el significado de

Schrödinger decía que

Se podría caer en la tentación de asociar la función

con un proceso vibratorio en el átomo, probablemente más real que las órbitas electrónicas, cuya realidad se cuestiona cada vez mas. (…) He preferido presentarla [la nueva formulación] en términos puramente matemáticos, que permite destacar lo que, en mi opinión, es el punto esencial: el hecho de de que la misteriosa “exigencia de valores enteros” ya no requiere ninguna regla de cuantización, sino que resulta de las condiciones de finitud y univalencia de una cierta función... Parece innecesario señalar cuánto más gratificante resulta concebir una transición cuántica como un cambio energético de un estado vibratorio a otro, que considerarla como un “salto” de electrones... ” (Bombal 2002)

Schrödinger esperaba que, además de predecir correctamente los resultados del experimento, una teoría física debería proveer una imagen espacio-temporal de los sistemas físicos que conllevaban a resultados experimentales y que el propósito de las leyes matemáticas de la teoría era explicar el comportamiento de estos sistemas en el espacio y en el tiempo. La primera etapa de su trabajo se centró en buscar un modelo de los microsistemas subyacentes a los fenómenos atómicos y moleculares. De acuerdo a las formulaciones estudiadas, las perspectivas de Schrödinger, estarían más acorde con las propuestas de Hacking, para quien las propuestas estarían más en el marco de la práctica científica. Frente a la propuesta de modelos productores, esperaría que no solo tuviera un valor epistémico sino que los medios representacionales estuvieran en el marco pluralista en el sentido de buscar una mayor amplitud a sus modelos.

Buscó una descripción más detallada de tal modelo y la formulación de una ecuación matemática que gobernara su comportamiento. La ecuación planteada no proporcionaba una descripción directa de los sistemas subyacentes como había esperado[17]. Su búsqueda fue exitosa en el sentido de que la ecuación era propicia para salvar los fenómenos. En la segunda etapa de su labor sobre la mecánica ondulatoria trató de desarrollar una teoría basada en la ecuación de onda, ideando nuevas maneras de aplicarla o formularla dependiente del tiempo y, procurando hallar un nuevo modo de vincular sus ecuaciones formales con un modelo de los microsistemas. Sin embargo, esta búsqueda de modelos espacio-temporales no consiguió dar con los frutos esperados, pues “átomos, electrones, luz y energía radiante fueran susceptibles de una descripción uniforme, conceptualmente paradójica, pero de una limpieza sin mácula desde el punto de vista matemático”(Arana 2000:18) La mayor parte de los símbolos de la teoría están identificados con conceptos espacio-temporales y la elección de las ecuaciones mecánico-cuánticas adecuadas para la aplicación a un fenómeno macroscópico dependen del empleo de uno o más modelos espacio-temporales de los microprocesos subyacentes. Como la ecuación funcionaba, la tarea era proporcionar una imagen física más completa, en la que fuera explícita la conexión entre la teoría y el movimiento de las ondas materiales y, esto lo consiguió con la articulación de la mecánica de matrices y la ondulatoria.

A pesar de su rechazo del formalismo de la mecánica de matrices, Schrödinger también estaba convencido de que ambos modelos se complementaban mutuamente. Y así, en la primavera de 1926, descubrió lo que llamo “una identidad matemática formal” entre la mecánica ondulatoria y la mecánica de matrices. Desde un planteamiento estrictamente formal, Schrödinger probó que la mecánica ondulatoria implicaba los aspectos básicos de la mecánica de matrices en los casos simples de espectro discreto. Estas ideas fueron marcando el derrotero hacia la teoría de transformaciones de Dirac y Jordan primero, y luego la posterior unificación de Von Neumann. Al mismo tiempo, sirvieron para decantar el desarrollo conceptual moderno de la Mecánica cuántica.

¿Por qué tanto empeño en elaborar descripciones espacio-temporales de los sistemas? “Una respuesta probable y tal vez generalmente aceptada es que era un realista científico, de los que creen que la tarea de la ciencia es describir la fábrica real del mundo” ”(Arana 2000:17). Como lo expresa él mismo, “las observaciones, y los resultados de las mediciones particulares, son la respuesta de la naturaleza a nuestra indagación. Así, de manera esencial, no sólo sean una ocasión del objeto, sino, antes bien una ocasión de la relación intercambiante sujeto-objeto” (Schrödinger 1975:37). Un modelo matemático más realista es la asociación de movimiento de la partícula con la superposición de un número infinito de ondas planas. En este acercamiento, el movimiento de una partícula libre puede representarse por un paquete de ondas. Esto explica la relación entre la partícula y movimiento de la onda de manera lógica y consistente.